近日,针对现有通用视觉语言模型CLIP在零样本异常检测任务中存在的“异常不敏感”问题,中国科学技术大学等科研团队提出了一种名为 AA-CLIP(Anomaly-Aware CLIP) 的新型异常检测方法。该方法有效提升了CLIP模型在异常与正常样本之间的判别能力,并在工业缺陷检测和医学病灶识别等多个实际场景中取得了领先性能。该成果以“AA-CLIP: Enhancing Zero-Shot Anomaly Detection via Anomaly-Aware CLIP”为题发表在计算机视觉领域顶级会议CVPR 2025(IEEE/CVF Conference on Computer Vision and Pattern Recognition)上,并在多项基准测试中取得了最新的最优结果。

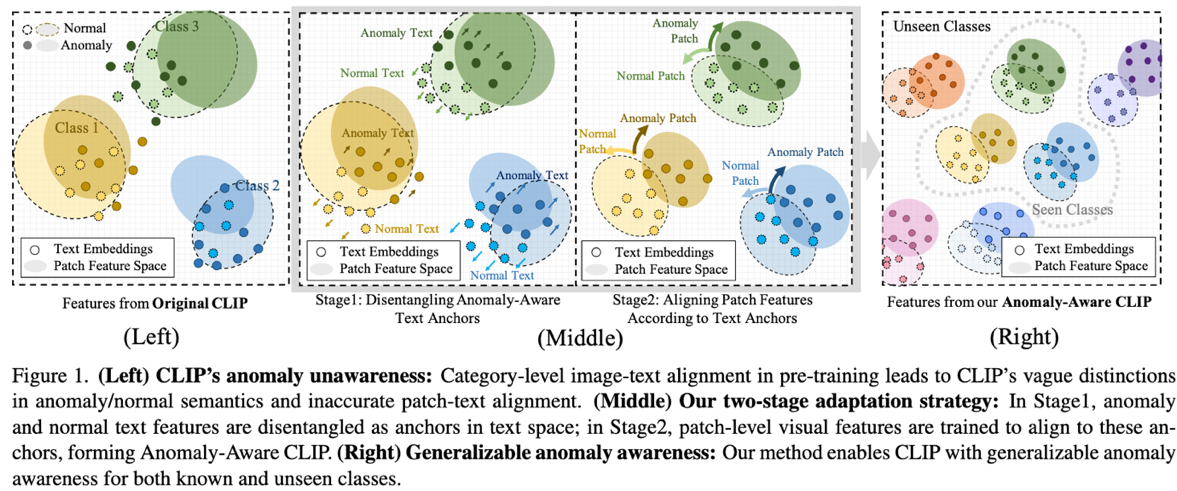

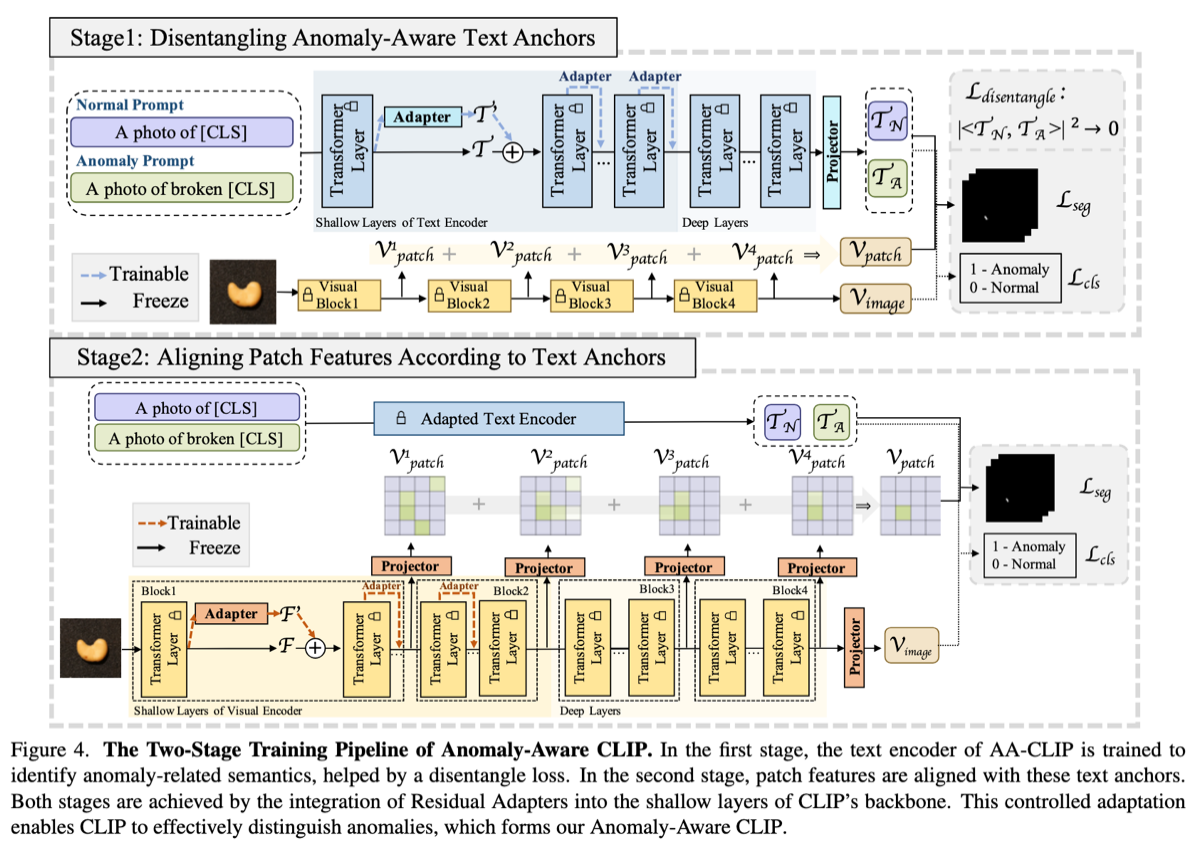

CLIP因其出色的跨模态泛化能力而被广泛应用于零样本学习任务,但在面对异常检测时,由于缺乏异常感知能力,容易出现识别混淆。为此,研究团队设计了一种简洁高效的两阶段训练方案,构建“异常感知”的文本锚点,用于区分正常与异常语义;随后将图像中每个局部区域的视觉特征与这些锚点进行对齐,实现精细的异常定位。该方法引入了残差适配器机制,在不破坏CLIP原有知识的基础上,逐步引导模型适应异常检测任务,从而兼顾性能与泛化能力。

大量实验证明,AA-CLIP在多个工业和医学图像数据集上均优于现有方法,具备良好的资源效率和实际应用潜力。这一研究为通用模型在高风险视觉任务中的部署提供了重要技术支撑,有望推动智能检测系统在制造和医疗等关键领域的进一步落地。