近日,MIRACLE团队在国际人工智能顶级会议 IJCAI 2025上发表了题为《MVP-CBM: Multi-layer Visual Preference-enhanced Concept Bottleneck Model for Explainable Medical Image Classification》的最新研究成果。该工作第一作者为博士生王春江,周少华教授与张坤博士后为共同通讯作者,研究单位包括中国科学技术大学苏州高等研究院、生物医学工程学院,讯飞医疗以及江苏省多模态数字孪生技术重点实验室等。

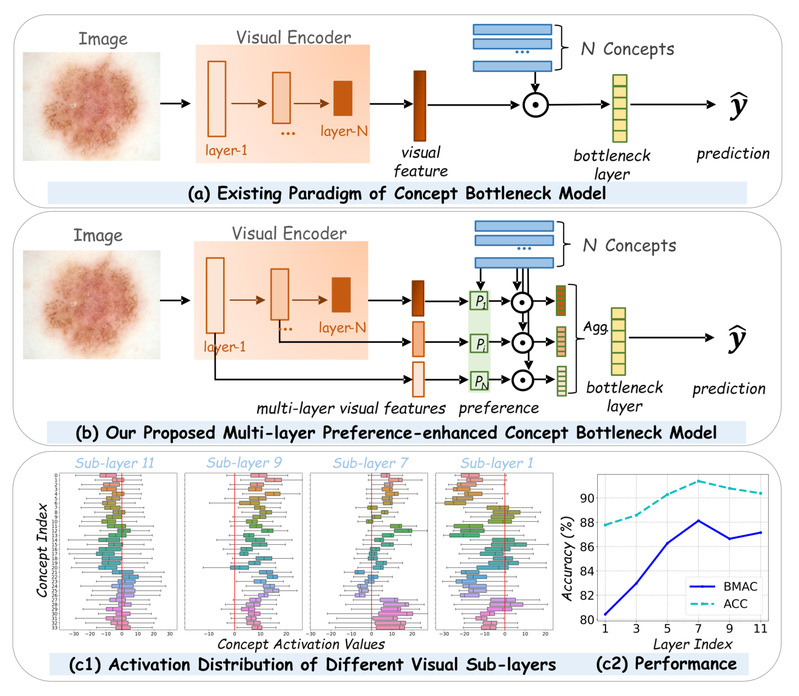

图1

近年来,概念瓶颈模型(Concept Bottleneck Model, CBM)通过引入人类可理解概念(如皮肤病变的“草莓模式血管”、乳腺肿块的“边界清晰度”)来增强可解释性,成为备受关注的研究方向。现有方法通常仅利用视觉编码器最终层的特征关联人类可理解概念(如皮肤病变的"草莓模式血管"或乳腺肿块的"边界清晰度"),但实证发现不同概念对视觉层级的偏好存在显著差异,此现象称为概念偏好差异(Concept Preference Variation),如图1所示。

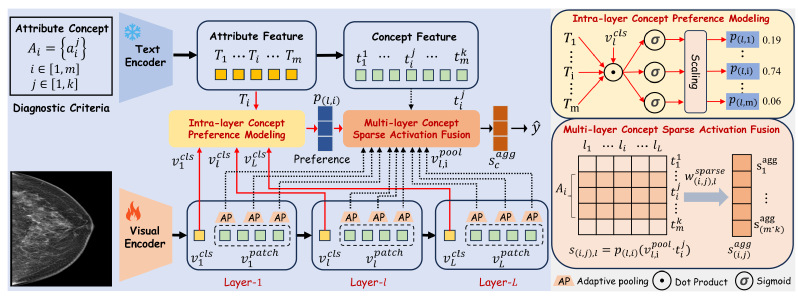

图2

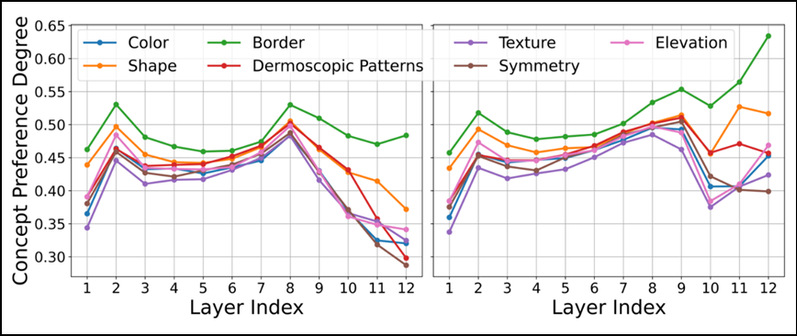

为解决此局限,MVP-CBM提出双模块协同架构,如图2所示。层内概念偏好建模(ICPM) 模块通过拼接同属性概念文本生成全局语义特征,计算其与每层视觉特征的相似度,结合可学习参数动态量化层级偏好强度。该机制精准捕获如图3所示的层级偏好规律。

图3

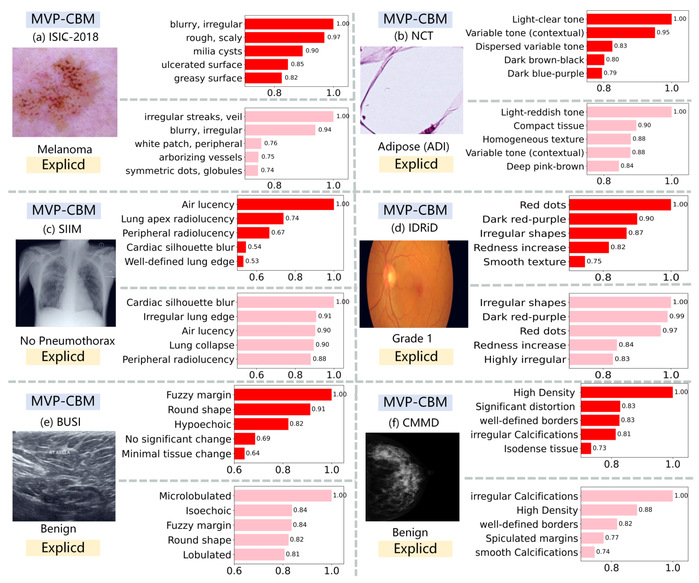

该方法在7个医学影像基准测试中实现性能与解释性双重突破。在ISIC2018皮肤病变分类任务中,平衡准确率达87.83%(较最优基线提升0.98%),BUSI乳腺超声分类准确率93.29%(领先3.4%),CMMD乳腺X光分类平衡准确率提升7.75%。可解释性验证表明,MVP-CBM的Top-5概念激活更符合医学诊断逻辑:如图4所示,乳腺X光良性肿块诊断中模型正确聚焦"边界清晰""高密度"等核心指标,而对比方法因过度关注"不规则钙化"导致恶性误诊。该研究发表于国际人工智能顶级会议 IJCAI 2025,首次揭示视觉层级-概念偏好关联机制,为高风险医疗决策提供兼具高精度与强解释性的可信AI框架。

图4

为了更深入地了解该项工作的幕后故事,有幸采访了论文作者,请他分享科研历程中的心路点滴。

Q1:您是如何得到此个工作的灵感的?

A1:灵感源于对可解释AI长期的思考。我们在研究过程中发现,不同医学概念其实更依赖视觉编码器的不同层级特征,但现有方法往往只关注最后一层,这与临床医生分层观察病灶的逻辑并不一致。这个差异启发了我们去系统性地建模“层级偏好”,也逐渐孕育出了MVP-CBM的核心想法。

Q2:在过程当中遇到过什么困难,又是如何克服的?

A2:最初的困难在于如何平衡“模型性能”和“解释稀疏性”。如果过度聚合多层特征,会带来噪声和冗余;但如果过度压缩,又可能损失关键信息。我们尝试过多种融合机制,甚至一度陷入瓶颈,最后才通过引入可学习的稀疏化机制找到突破口。这个过程虽然艰难,但也让我们更加深刻理解了“解释一致性”的本质。

Q3:在此个工作当中,有哪些收获?

A3:最大的收获是意识到“解释”并不是附加的,而应当融入模型设计的核心。通过MVP-CBM,我们不仅提升了性能,更重要的是让AI的输出逻辑真正贴近医生的思维方式。这种跨学科的融合让我对医学AI的未来应用有了更大的信心。